בזמנו כתבתי בבלוג סדרת פוסטים על חשבון אינפיניטסימלי. הצגתי בסדרה הזו את שלושת המושגים הבסיסיים שעליהם החשבון האינפיניטסימלי נשען - הגבול, הנגזרת והאינטגרל - אבל לא הלכתי יותר מדי רחוק אחר כך (אפילו לנושא כמו טורים לא הגעתי).

בעקבות בקשה שהגיעה אלי, אני רוצה להתחיל להשלים חלק מהחורים שהשארתי. ספציפית, אני רוצה לטפל באנליזה וקטורית (אצלי "אנליזה וקטורית" היא דרך מקוצרת לומר "חשבון אינפיניטסימלי במספר משתנים; אני מודע לכך שלפעמים משתמשים בשם הזה כדי לתאר תחום ספציפי יותר). הרעיון הבסיסי של התחום הוא - יופי, אז יש לנו חשבון אינפיניטסימלי של פונקציות \(f:\mathbb{R}\to\mathbb{R}\) - פונקציות ממשיות במשתנה יחיד. זה לכשעצמו כבר תחום חזק ומועיל ביותר, אבל בעולם האמיתי יש לנו הרבה פונקציות מורכבות יותר - כאלו שמקבלות כמה משתנים, ואפילו מחזירות כמה ערכים; באופן כללי, פונקציות \(f:\mathbb{R}^{n}\to\mathbb{R}^{m}\). האם ניתן להכליל את מושגי הגבול, הנגזרת והאינטגרל גם עבורם? התשובה היא כמובן "כן", והתוצאה היא אחד התחומים החשובים ביותר במתמטיקה, וכזה שיש לו אינסוף שימושים יישומיים (למשל, בלי התחום הזה אין פיזיקה).

כפי שאתם ודאי מנחשים, אני הולך להניח שאתם כבר מכירים חשבון אינפיניטסימלי של פונקציות ממשיות במשתנה יחיד. אם אתם לא מכירים - נסו לקרוא את סדרת הפוסטים שלי (או לקחת ספר לימוד). אולי קצת פחות ברור כרגע הוא תחום נוסף שאני אניח שאתם כבר מכירים - אלגברה לינארית בסיסית. הסיבות לכך יתבררו עוד מעט.

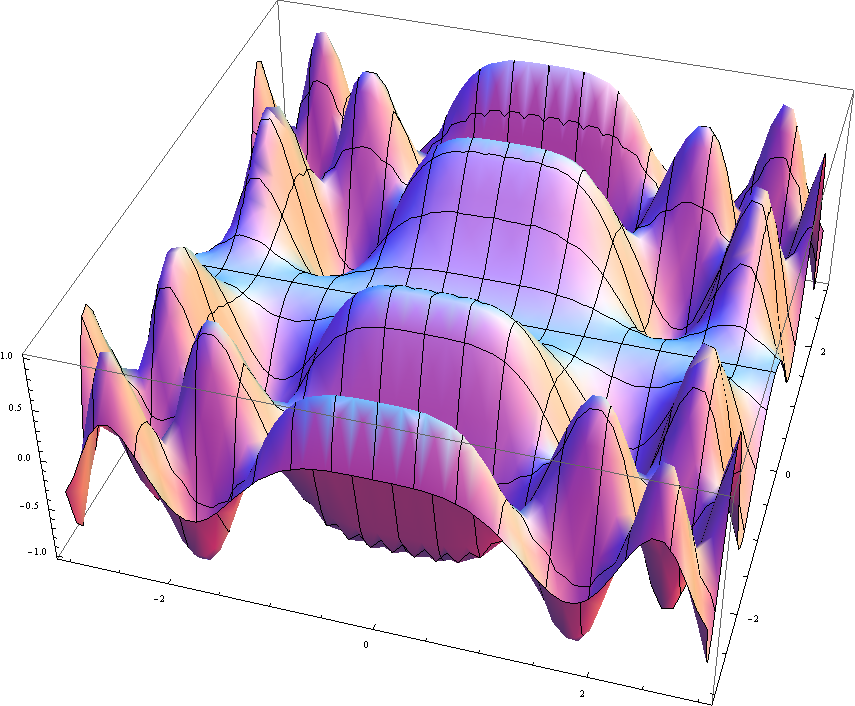

בפוסט הזה אני רוצה לתת סקירה כללית של הנושאים שאנחנו מדברים עליהם, בלי להיכנס יותר מדי לפורמליזם. ראשית נתחיל עם הצגת שדה המשחק, שהוא כאמור פונקציות \(f:\mathbb{R}^{n}\to\mathbb{R}^{m}\) מכיוון שזו דרך הצגה מאוד כללית, הרבה פעמים כשאני ארצה לתת דוגמה קונקרטית, אני אלך למקרה הלא טריוויאלי הראשון: פונקציה ממשית בשני משתנים, \(f:\mathbb{R}^{2}\to\mathbb{R}\). למשל \(f\left(x,y\right)=x+y\) או \(f\left(x,y\right)=\sin x\cos y\) וכדומה. ויזואליזציה נחמדה לפונקציה שכזו היא בתור גובה פני השטח במפה: לכל קואורדינטת \(\left(x,y\right)\) מותאם גובה \(f\left(x,y\right)\) שהוא מספר ממשי. זה נראה ככה (תמונה באדיבות ויקיפדיה האנגלית):

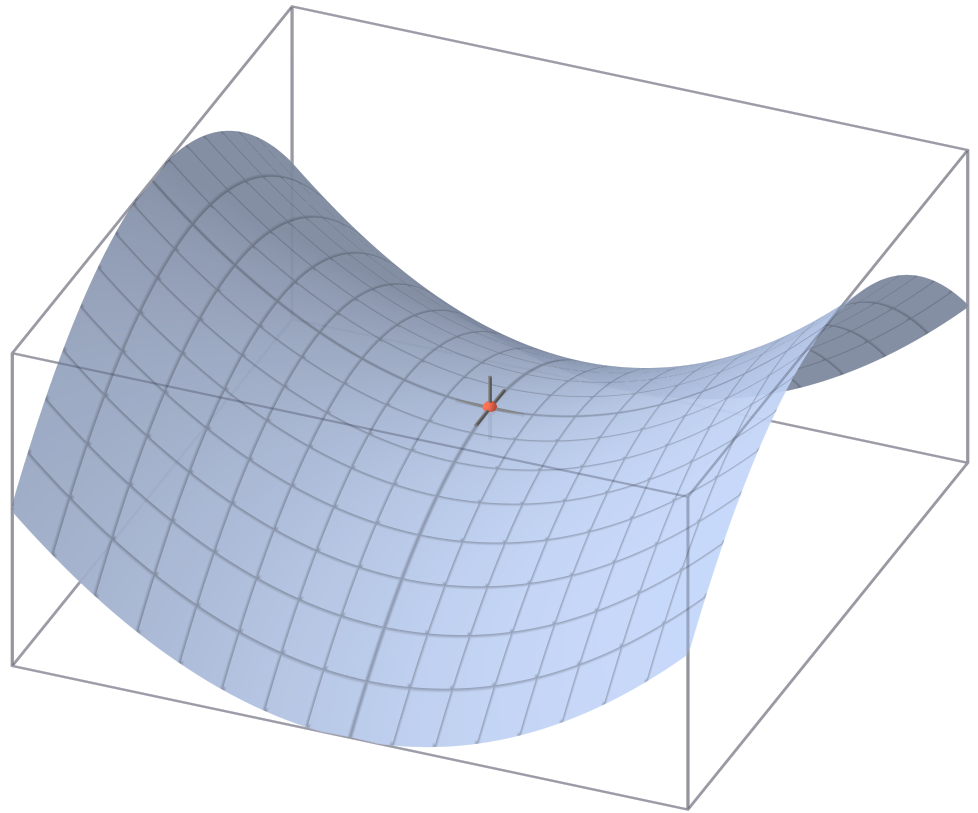

כלומר, מין הר שכזה. עכשיו אפשר לנסח שתי שאלות על היצור הזה: ראשית, נניח שאנחנו נמצאים בנקודה מסויימת; כמה תלול ההר באותה נקודה? שנית, בואו ניקח שטח תחום כלשהו מההר - מה הנפח שלו? כלומר, כמה סלעים יש בפנים? על השאלה הראשונה עונים באמצעות נגזרות, ועל השאלה השניה באמצעות אינטגרלים. רק שהסיפור יותר מסובך כאן מאשר במימד אחד. למשל, הביטו על האוכף הזה (שוב, תודה לויקיפדיה האנגלית):

במרכז האוכף, מה קורה? האם אנחנו עולים או יורדים? ובאיזה קצב? נראה שזה תלוי בכיוון שאנחנו הולכים בו. כבר אי אפשר לדבר על נגזרת רגילה, צריך לדבר על "נגזרת עבור כיוון מסויים" - נגזרת מכוונת. אבל מתברר שיש גם דרך לדבר בצורה כלשהי על "הנגזרת לכל הכיוונים בבת אחת", פשוט לא נקבל מספר כמו קודם אלא טרנספורמציה לינארית. מעט בעייתי להסביר את זה בלי להיכנס לפורמליזם (שאכנס אליו בפוסט הבא), אבל זהו הרעיון: בפונקציות ממשיות במשתנה יחיד, הנגזרת של פונקציה \(f\) בנקודה מסויימת הייתה בסך הכל מספר ממשי ("המספר הנגזר"). המספר הזה נתן לנו את "קצב השינוי הרגעי" של הפונקציה באותה נקודה, אבל יש גם דרך התבוננות גאומטרית על זה: הנגזרת בנקודה נתנה לנו את שיפוע המשיק לגרף הפונקציה באותה נקודה. אבל מה זה "משיק"? זה קו ישר שעובר דרך הנקודה הזו ו"נראה בערך כמו הפונקציה" באותה נקודה. עכשיו בואו ניקח את הרעיון הזה צעד קדימה. קו ישר הוא טרנספורמציה לינארית: הוא פונקציה מהצורה \(T\left(x\right)=ax+b\), ואנחנו יכולים בלי הגבלת הכלליות להתייחס לנקודה שבה אנו מחשבים את הפונקציה בתור ראשית הצירים כדי לקבל ש-\(b=0\), כלומר \(T\left(x\right)=ax\) כאשר \(a\) הוא המספר הנגזר של \(f\) בנקודה 0 הזו (\(a=f^{\prime}\left(0\right)\)). אפשר להוכיח שבמובן מסויים, \(T\) הזו מהווה קירוב טוב ל-\(f\) בסביבות הנקודה 0. לקירוב הזה קוראים דיפרנציאל של \(f\) בנקודה 0.

מה שעושים באנליזה וקטורית הוא להכליל בראש ובראשונה את מושג הדיפרנציאל הזה. אם \(f:\mathbb{R}^{n}\to\mathbb{R}^{m}\) אז הדיפרנציאל של \(f\) בנקודה מסויימת יהיה טרנספורמציה לינארית \(T:\mathbb{R}^{n}\to\mathbb{R}^{m}\) שמהווה קירוב טוב ל-\(f\) באותה נקודה.

פרט למושג הדיפרנציאל, ניתן לדבר על מה שתיארתי קודם - נגזרות מכוונות. בפרט, נגזרות שמכוונות בכיוון הצירים של המשתנים. נגזרות כאלו נקראות נגזרות חלקיות של \(f\) והן חשובות בפני עצמן; בדרך כלל הן קשורות בקשר הדוק לדיפרנציאלים של הפונקציה, אבל ייתכנו דוגמאות פתולוגיות שבהן יש לפונקציה דיפרנציאל אבל אין נגזרות חלקיות, וההפך.

בשלב הזה אפשר להקים לתחיה דיונים מאינפי של פונקציות ממשיות - איך מחשבים את הדיפרנציאל הזה? (בעזרת אינפי של פונקציות ממשיות). האם מתקיים כלל השרשרת? (כן). האם אפשר להשתמש בו כדי למצוא נקודות מינימום ומקסימום? (כן). האם קיימת הכללה של קירוב טיילור עבור פונקציה בכמה משתנים? (כן). ויש גם דיון שבפונקציות ממשיות רגילות הוא כמעט טריוויאלי והופך למורכב ומעניין פי כמה וכמה בהקשר הזה - באילו תנאים קיימת הופכית מקומית לפונקציה דיפרנציאבילית? המשפט הרלוונטי (משפט הפונקציה ההפוכה) הוא ההוכחה ה"כבדה" הראשונה שצצה בתחום הזה, ומייד אפשר לתת לה שימוש יפה במשפט הפונקציות הסתומות, שהוא משהו שאין לו מקבילה באינפי של משתנה יחיד, שעוסק בשאלת היכולת שלנו "לחלץ" משתנה מתוך ביטוי; למשל, המשוואה \(x^{2}+y^{2}=1\) מגדירה בצורה כלשהי את \(x\) כפונקציה של \(y\), כפי שאפשר לראות על ידי החילוץ לדוגמה \(x=\sqrt{1-y^{2}}\) - אבל האם תמיד אפשר לבצע חילוץ שכזה? והאם הוא יחיד? (במקרה שלנו, כמובן, גם \(x=-\sqrt{1-y^{2}}\) עובד) - זה מה שמשפט הפונקציות הסתומות מתעסק בו.

ואז מגיעים לאינטגרלים והכל משתגע.

יש שתי הצגות של מה שאדבר עליו עכשיו. אתחיל מזו ה"קלאסית" ואז אזכיר ברמז את המודרנית יותר. אני מקווה שגם בפוסטים העניינים יתנהלו כך.

על פניו, ההכללה של אינטגרל רימן לממדים גבוהים יותר היא טבעית יחסית. אינטגרל רימן התקבל מסדרת קירובים באמצעות מלבנים? אז עכשיו ניקח קירובים באמצעות קוביות וכן הלאה. זה אכן הרעיון הבסיסי, והוא מניב בדו ותלת מימד את מה שנקראים "אינטגרל כפול" ו"אינטגרל משולש", בהתאמה (ואפשר לדבר גם על ממדים גבוהים יותר). אבל חיש קל עולה השאלה איך מחשבים דבר כזה - והתשובה היא שבאמצעות אינטגרל "רגיל", כמובן; זה מה שנקרא משפט פוביני, שמראה איך אפשר (לרוב, לא תמיד) לחשב אינטגרל כפול באמצעות חישוב שני אינטגרלים רגילים, ואינטגרל משולש באמצעות חישוב שלושה - הבנתם את הרעיון.

זה עדיין לא מסיים את העניין, כי טכניקת אינטגרציה נפוצה מאוד - החלפת משתנים - הופכת לקריטית עוד יותר בממדים גבוהים. המשפט שמטפל באופן שבו ניתן לבצע החלפת משתנים הוא עוד תוצאה כבדה למדי.

אבל האינטגרלים לא נגמרים כאן. אפשר לעבור לדבר על סוג אחר של אינטגרלים - אינטגרל קווי ואינטגרל משטחי. וכאילו שאין די בצרות, יש שני סוגים של כל אחד מהאינטגרלים הללו. נדבר על אינטגרל קווי: הסוג הראשון עוסק בסיטואציה שבה יש לנו פונקציה סקלרית כלשהי על מרחב \(n\)-ממדי (\(f:\mathbb{R}^{n}\to\mathbb{R}\)) ואנחנו לא רוצים לחשב אינטגרל דו-ממדי שלה, אלא רוצים לשאול את השאלה מה האינטגרל ה"רגיל" שלה כשהוא נלקח על אובייקט חד ממדי - עקומה כלשהי שחיה ב-\(\mathbb{R}^{n}\). הסוג השני הוא אינטגרל של פונקציה וקטורית, כלומר פונקציה \(F:\mathbb{R}^{n}\to\mathbb{R}^{n}\). דוגמה אינטואיטיבית מאוד לעניין הזה, למי שמכיר פיזיקה, היא עבודה: אם אנחנו רוצים לחשב את השינוי באנרגיה הקינטית של גוף שנע בתוך שדה כוח כלשהו (זו הפונקציה \(F\)) במסלול מסויים (זו העקומה שעליה מבצעים את האינטגרל) צריך לחשב את האינטגרל הקווי של \(F\) על העקומה. עבור אינטגרל משטחי, הסיפור דומה, אבל במקום אינטגרציה על עקומה חד ממדית, אנחנו רוצים לבצע אינטגרציה על משטח דו ממדי.

ואז כדי לסיים את זה מגיעים כמה משפטים כבדים שמראים כל מני קשרים בין סוגי האינטגרלים הללו - משפט גרין, משפט גאוס, ומשפט סטוקס. בנפנוף ידיים פרוע, משפט גרין מראה שב-\(\mathbb{R}^{2}\), חישוב של אינטגרל כפול של פונקציה על תחום מסויים זהה לחישוב של אינטגרל קווי של פונקציה אחרת שמתקבלת ממנה, על השפה של אותו תחום. משפט גאוס עושה את אותו הדבר עבור \(\mathbb{R}^{3}\), עם המרה בין אינטגרל משולש ואינטגרל משטחי על שפת התחום שבו מבצעים את האינטגרציה המשולשת. משפט סטוקס נשאר ב-\(\mathbb{R}^{3}\) ומראה קשר דומה בין אינטגרל משטחי ובין אינטגרל קווי על השפה של המשטח.

כל העסק הזה נראה כמו בלאגן אחד גדול, והוא אכן כזה; למרבה המזל, המתמטיקה המודרנית מגיעה לעזרה. כדי להכליל את כל ערב-רב המושגים שתיארתי קודם, מכניסים לתמונה מושג שנקרא תבנית דיפרנציאלית, ובעזרתו אפשר להוכיח משפט שממנו גרין, גאוס וסטוקס הולכים להיגזר כמקרים פרטיים. המשפט הכללי נקרא (באופן ממש לא מבלבל) משפט סטוקס (זה "ה"משפט סטוקס; משפט סטוקס שתיארתי קודם נקרא "חוק סטוקס" או "משפט סטוקס הקלאסי" וכדומה כדי להבדיל ביניהם). הניסוח שלו הוא מאוד פשוט ונקי:

\(\int_{M}d\omega=\int_{\partial M}\omega\)

צריך לקרוא את זה כך: אם \(\omega\) היא תבנית דיפרנציאלית ו-\(M\) היא תחום כלשהו שמקיים כך וכך ("יריעה דיפרנציאלית קומפקטית מכוונת") אז האינטגרל של \(\omega\) על שפת \(M\) שווה לאינטגרל של הנגזרת של \(\omega\) על \(M\).

כמובן, בלי להבין את המושגים שנכללים בהגדרת המשפט אי אפשר להבין עד הסוף מה הולך כאן, אבל אני חושב שאפשר להעריך את הפשטות של התיאור הזה כבר כעת.

משפט סטוקס הזה הוא סוג של גביע קדוש בתחום - הוא מהווה הכללה של המשפט היסודי של החדו"א. גם בלי להבין את המושגים עד הסוף, אפשר לראות את זה די בקלות: באינטגרל "רגיל", התחום \(M\) שלנו הוא קטע \(\left[a,b\right]\). ה"שפה" של תחום כזה היא בסך הכל הנקודות \(\left\{ a,b\right\} \). אם \(F\) היא פונקציה כלשהי שאנחנו חושבים עליה כעל תבנית דיפרנציאלית (תבנית דיפרנציאלית היא הכללה של פונקציות), אז \(dF=f\) היא הנגזרת הרגילה שלה. לכן אנחנו מקבלים ש-\(\int_{a}^{b}f\) שווה ל"אינטגרל" של \(F\) על הנקודות \(\left\{ a,b\right\} \) - מה שיוצא \(F\left(b\right)-F\left(a\right)\). למה אחד מהם הוא חיובי והשני שלילי? זה נובע מהכיווניות של ה"יריעה" שכוללת את שתי הנקודות הללו; אסביר את הפרטים הטכניים כשאגיע אליהם, בתקווה.

אם כן, זה הרעיון הכללי ואלו הדברים שאני מקווה שיצא לי להציג (גם אם לא ברצף, ראו בפוסט הזה התחייבות כלשהי לעתיד). אני מקווה שיהיה מעניין לפחות כשם שיהיה שימושי.